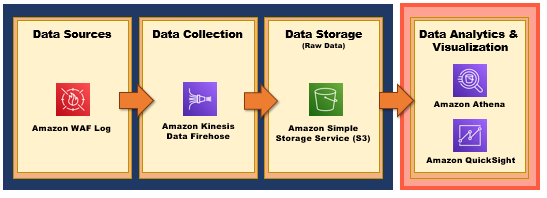

今天我們要來實作 - 『如何啟用 WAF 日誌以及匯入 BI 進行分析』,

Data Analytics Pipeline 如下圖所示:

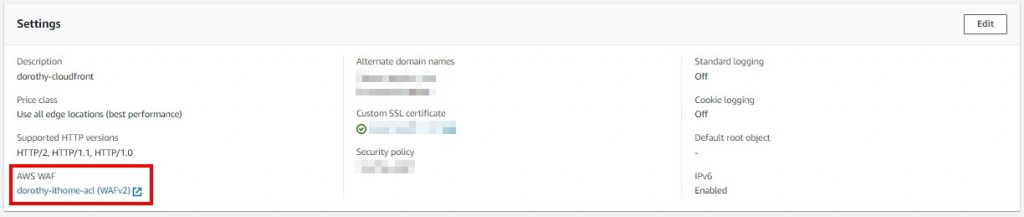

再做這個實作之前,大家要先部屬 AWS WAF 至 CloudFront 上喔 ~

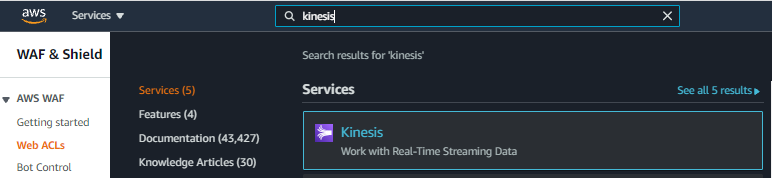

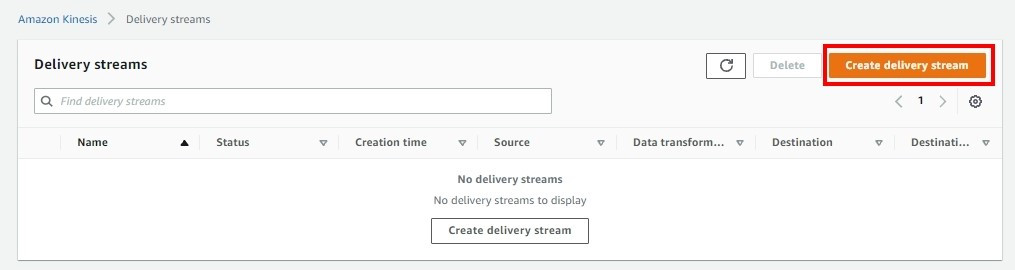

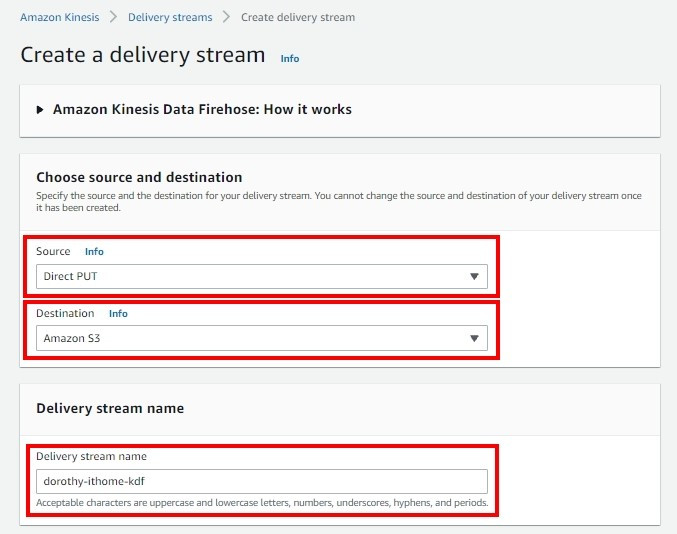

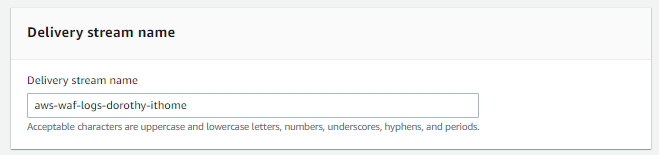

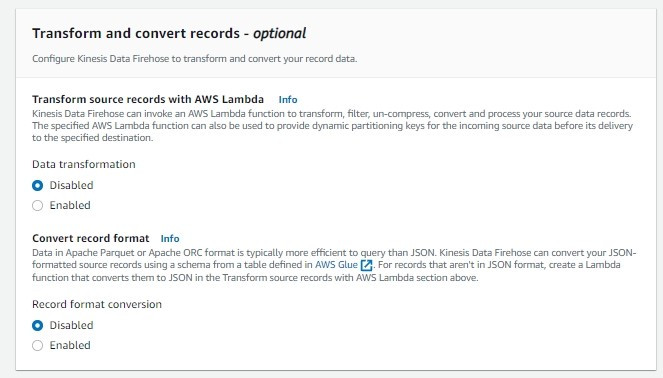

那再啟用 WAF Log 之前,我們必須要先建立 AWS Kinesis 服務,那我們就開始吧 GOGO

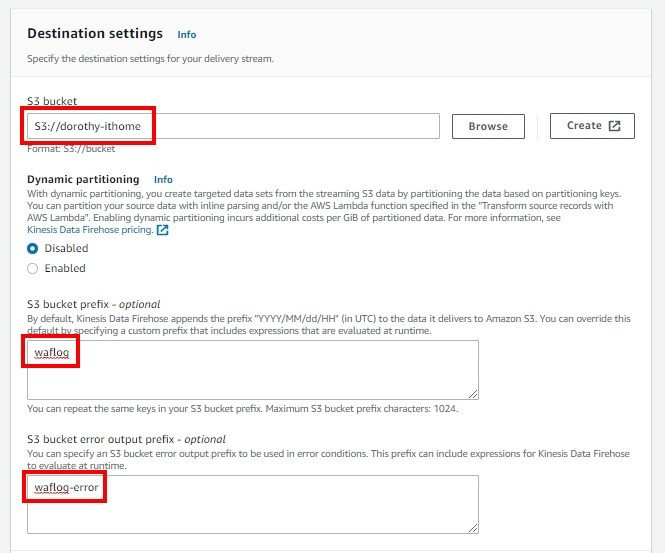

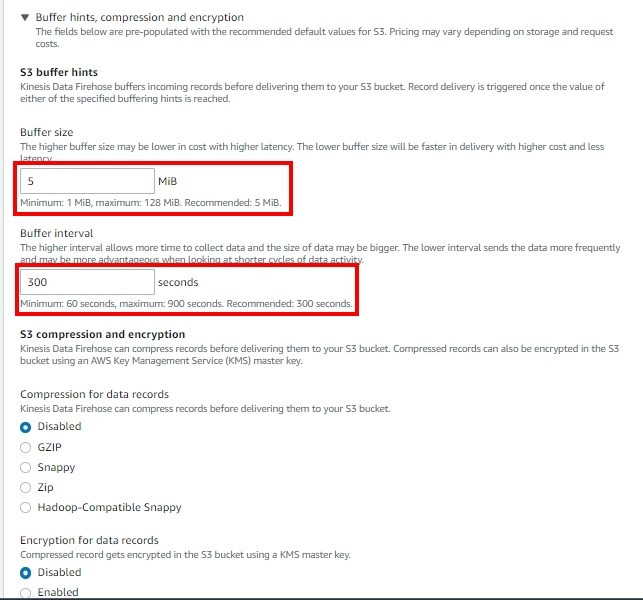

Buffer size 跟 Buffer interval 就是如果當 Buffer 超過 5 MiB或者超過 300 秒後會將串流資料丟到 AWS S3上

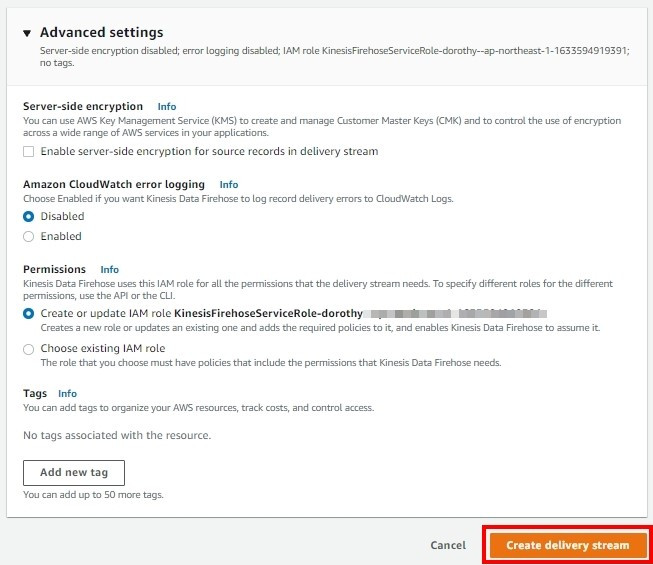

接著確認無誤後按 Create delivery stream

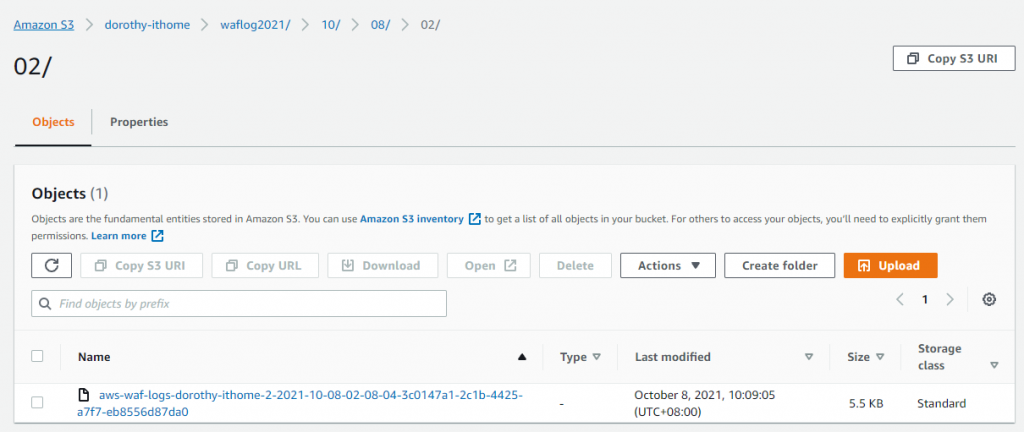

今天我們順利建立好 AWS Kinesis Data Firehose,那大家就可以看到 AWS S3 已順利產生資料也~

明天我們就會來討論『如何啟用 WAF 日誌』,明天見囉 : D ~

如果有任何指點與建議,也歡迎留言交流,一起漫步在 Data on AWS 中。

參考&相關來源:

[1] Kinesis Data Firehose

https://docs.aws.amazon.com/firehose/latest/dev/create-configure.html